【漫画】第36話「検索順位を上げる方法とは?SEOは良質なコンテンツ作りがベスト」

「検索順位を1位にしたい」

「コンテンツとリンク」

「結局は良いコンテンツ」

「ついに初報酬ゲット!?」

- SEOの3つの基礎知識とは?

- Googleの評価基準「E-E-A-T」で進める

- E-E-A-T① 経験者は初心者より信頼できる

- E-E-A-T② 専門家は素人より信頼できる

- E-E-A-T③ 権威者は無名より信頼できる

- E-E-A-T④ 信頼できる運営元や執筆者である

- 検索順位の上げ方でよくある質問

- SEOの体験談や口コミ

SEOの3つの基礎知識とは?

SEO基礎① 検索順位はアルゴリズムで動く

サイトにユーザーを集めるためにキーワードやコンテンツを改善する技術をSEO(Search Engine Optimization)と呼びます。狭義では「検索順位を上げてアクセス数を増やす=SEO」とも認識されています。

statcounterの2024年10月時点の「Search Engine Market Share Japan」によると、検索エンジンのシェアはGoogleが80.2%、Yahoo!が10.2%、bingが8.2%でした。ただし、GoogleとYahoo!は同じGoogleの検索エンジンを使っていることから、実質的にGoogleのみでシェア90%に達しています。つまり、SEOではGoogleの検索エンジンのみが対象です。

私たちもSEOを勉強すると、キーワードやコンテンツを最適化できるようになり、検索順位を上げることができます。結果的に訪問者数が増えて、サイトの収益が上がっていくでしょう。

ただ、初心者が任意のキーワードでいきなり1位を獲得することは難しいです。なぜなら検索順位は「アルゴリズム」と呼ばれる複雑で難解な法則に基づいて決められているからです。

検索アルゴリズムには数百以上の指標があり、簡単に述べると「titleタグにキーワードが含むと+8点、文章がユニークであると+5点、別のサイトからリンクを貰っていると+3点」のようなイメージで採点されています。

ただし、この採点方法は特許として部分的に公開していますが、大学の理工学部で学ぶ線形代数を基礎にしており、それを理解したからといって1位になれる内容でもありません。

そもそも検索アルゴリズムが見破られて、検索順位が不正に操作されないように、Googleは日進月歩で検索アルゴリズムを進化させています。その中にはランクブレインという人工知能も含まれているため、Googleの社員ですら1位になる方法を具体的には説明できません。

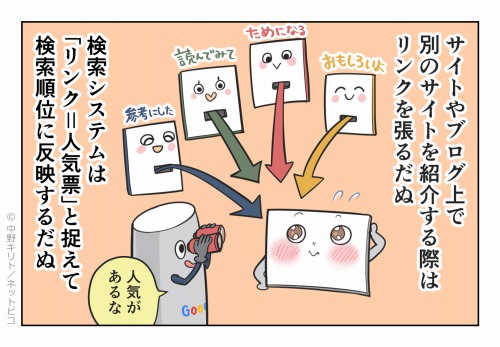

SEO基礎② 検索順位はコンテンツで上がる

Googleの検索アルゴリズムはブラックボックスであり、詳細が不明確です。しかしながら、検索アルゴリズムの根底にある「ユーザーに役立つオリジナルのコンテンツを提供している」と「ユーザーから評価されて、別のサイトからリンクが貼られている」という2つのルールの重要性は変わっていません。

- ユーザーに役立つオリジナルの「コンテンツ」を提供している。

- ユーザーから評価されて、別のサイトから「リンク」が貼られている。

ただ、別のサイトやブログからリンクを貰うには良質なコンテンツが必要であることから、結局、私たちはリンクの獲得はあまり意識せず、シンプルに良質なコンテンツを作り続けることが最良のSEOになります。

SEO基礎③ 検索順位は不正行為で下がる

初心者の一部には「検索順位を上げるためには特別な何かが存在している」と認識している人もいます。確かに以前はGoogleの検索エンジンの質が低く、悪意のあるテクニックによって、意図的に検索順位を上げることができました。

2000~2003年は記事にキーワードを詰め込めば、目的のキーワードで上位表示されてしまいました。過剰なキーワードをユーザーには見せないように、小さい文字や白い文字などでテキストを隠す行為も横行します。

2004~2007年はリンクが非常に有効であり、お互いにリンクを載せる相互リンク、リンクを供給し合うリンクネットワーク、リンクの売買、コメントスパムなどで意図的にリンクを獲得することで、検索順位が上がりました。

2008~2011年には自然にリンクが張られたような工夫をするために、無料ブログを多数取得する人が増えました。自分のサイトと似たようなテーマの記事を投稿し、そこから自分のサイトへリンクを貼ります。

これら以外にも「誰かが捨てた中古ドメインを取得して、その運用歴による優位性を引き継ぐ手法」のような多数の裏技が出回り、確かに当時はそれだけで検索順位が上昇しました。

しかし、現在は通用しません。下手な対策はもはやスパム行為であり、検索順位が下がるリスクすらあります。Googleは全力でスパムを阻止します。それは意図的に検索順位が操作されると、平等性が保てない偏った検索結果になり、検索結果のクオリティが落ちるからです。その結果、使い勝手が悪くなり、ユーザーは離れていきます。

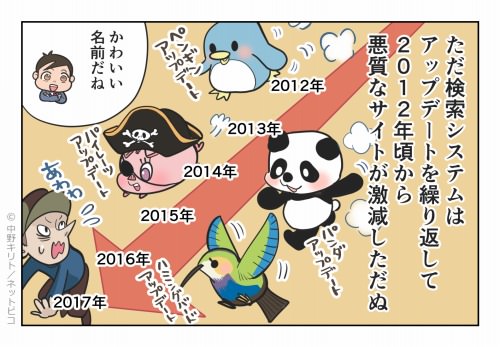

Googleの売上の80%以上は広告収入であるため、ユーザーが離れることは致命的です。そのため、Googleは検索順位が操作されないように、検索システムのアップデートを繰り返して、悪質なサイトを追い出しています。

例えば、2012年4月にリンク操作などのスパムを防止するペンギンアップデート、2012年7月に低品質なコンテンツの評価を下げるパンダアップデート、2012年8月に著作権の侵害を考慮したパイレーツアップデート、2013年9月に会話で検索できるようになったハミングアップデートなどです。

Googleを欺くような施策は短期間で無駄になりますし、逆にGoogleが望むことを優先的に意識する必要もありません。それはGoogleの理念に「ユーザーに焦点を絞れば、他のものはみな後からついてくる」があるからです。

つまり、私たちもユーザーのことだけを考えれば、それが結果的にGoogleが望んでいる最適なサイトになります。SEOとは「検索エンジン最適化」ではありますが、今は「検索ユーザー最適化」と捉えても構いません。

Googleの評価基準「E-E-A-T」で進める

Googleのアルゴリズムは日々改善されていますが、その検索結果の評価するための基準はGeneral Guidelinesに記載されており、この内容には一見の価値があります。要約すると「Googleがどのようなページを高評価や低評価にするか、その特徴や具体例」がわかります。

その中でも重要な評価基準が「E-E-A-T」です。E-E-A-Tとは「Experience(経験)、Expertise(専門性)、Authoritativeness(権威性)、Trustworthiness(信頼性)」の略であり、この4項目を高めることで順位に良い影響があるとされる概念です。

E-E-A-T① 経験者は初心者より信頼できる

E-E-A-Tの「E」である「Experience(経験)」についてです。経験者と初心者、あるいは未経験者による情報のうち、経験者による情報は信頼できるとしています。

当たり前ではありますが、経験者による情報は具体的であり、裏付けもあるために信用できます。逆にネットで集めただけの情報には価値がないとされます。

経験者の情報は独自性も高いです。独自性とはコピーやリライトではない、オリジナルの情報のことであり、情報元は「体験者本人による1次ソース、取材で得た2次ソース、既存を書き換える3次ソース」などに分けられます。Googleは1次や2次を重視しており、3次ソースはオリジナリティの不足と認識されやすいです。

ただし、3次ソースでも点在する情報をまとめあげ、判読性と読了率を高める工夫をすれば、ユーザーに役立つ情報になるため、Googleに評価されないわけではありません。

E-E-A-T② 専門家は素人より信頼できる

E-E-A-Tのもう1つの「E」である「専門性(Expertise)」についてです。専門家が持つ知識や経験から生み出される情報は、素人の情報よりも信頼できるとしています。

例えば、ユーザーが「関東 理系 大学」というキーワードで探しているなら、「全国トップクラスの予備校講師が監修した関東にある理系大学一覧」として、専門家によって専門性を保証しましょう。

また、SEOではページそのものの専門性も重視しています。ユーザーが「関東 理系 大学」で探したとき、「世界の大学一覧」「国内の大学一覧」「関東の理系の大学一覧」という3つがあったら、どの記事の評価が高いでしょう。Googleは正しく関東と理系に特化した「関東の理系の大学一覧」の記事を評価します。

このように専門性を高めるには「専門家が執筆する、専門家に取材をする、専門家が監修する、専門的な情報を増やす、専門性のあるテーマに絞る」といった方法があります。

E-E-A-T③ 権威者は無名より信頼できる

E-E-A-Tの「A」である「Authoriatativeness(権威性)」についてです。世間的な認知度が高い権威者の情報は、無名な人物よりも信頼できるとしています。

例えば、著書も出している園芸家と認知されていない一般人がまったく同じ「オリーブの育て方」の解説をした場合、園芸家のほうがSEOに権威があります。

その業界の専門家、有識者、著名人による情報の発信は権威性が高くなり、Googleに評価される傾向があります。特にYMYL(Your Money, Your Life)という人生に大きな影響を与える健康や金融のジャンルでは、検索順位に権威性が強く影響します。

権威性は主に高品質なリンクが増えることで上がっていきます。これは「高品質なリンクが多数ある=多くの人に支持されている」と評価されるためです。

さらにサイテーション(引用・言及)やレピュテーション(評判)も重視されています。その理由は記事を紹介するときにリンクを用いる人は、一部のサイトやブロガーなどに限られているからです。リンクよりも単なるテキストで引用や言及する人のほうが圧倒的に多いでしょう。

なかでも「政府機関、公共機関、学術機関、論文、新聞、ニュース、書籍」といった信用力がある媒体に、引用や言及されているページは権威性が上がります。

E-E-A-T④ 信頼できる運営元や執筆者である

E-E-A-Tの「T」である「Trustworthiness(信頼性)」についてです。サイトの運営元やページの執筆者が明記されたコンテンツのほうが、誰が書いたかわからないコンテンツより信頼できるとしています。

信頼性とはコンテンツの正確性や透明性を保証しているかが大切であり、会社名、住所、電話番号、メールアドレスを明記して、責任の所在が明らかになっている必要があります。

また、E-E-A-Tの経験、専門性、権威性、信頼の4つとも、すべて「信頼」につながっていることがポイントです。

これによって個人が金融や健康のジャンルで検索順位の上位を獲得することは難しくなりました。例えば「大学病院のサイトにて医師が写真付きの実例を解説した胃がんのページ」と「個人ブログにて素人が説明した胃がんのページ」では、経験、専門性、権威性、信頼性の評価がまったく違うでしょう。

経験は「医師としての包括的な体験談」、専門性は「医師による具体的で独自の実例」、権威性は「医師として多くの人が知っている」、信頼性は「大学病院のサイト内の記事で内容が正しい」で担保されているため、大学病院のサイトのほうが高品質と評価されて、キーワードが「胃がん」などの検索結果では上位に表示されます。

検索順位の上げ方でよくある質問

──情報を網羅したほうが順位は上がりますか?

ある程度は網羅したほうがいいです。コンテンツの網羅性とはユーザーが入力した検索キーワードに対して適切な量のコンテンツを提供していることです。

例えば、ユーザーが「検索エンジン最適化」と検索したとき、Aサイトは「検索エンジンの意味」のみ、Bサイトは「検索エンジンの意味のみではなく、検索順位が決まる仕組みから検索順位を上げる方法」まで載せています。この場合、GoogleはBサイトを検索結果の上位に表示するでしょう。

なぜならBサイトのほうが検索キーワードの裏側にある検索意図を汲み取って、ユーザーが知りたいとされる多くの情報を載せているからです。つまり、網羅性とは「より多角的に、より適合的に、より具体的に情報がある」状態です。

──読みやすいほうが順位は上がりますか?

文章の読みやすさであるコンテンツの可読性は、順位に影響します。いくら専門性、独自性、網羅性、権威性、信頼性が優れている内容でも、文章が読みにくい場合はGoogleは評価してくれません。ユーザーが正しく理解できる見た目、文章構成、文章力が必要です。

例えば、文章のみで伝えられる情報は限られるため、情報を可視化するオリジナルの写真、イラスト、表、グラフ、チャート、図解などは、ユーザーの理解度を深めてくれます。これも可読性を高める方法の1つです。

──情報の質と量が完璧であれば、順位は上がりますか?

SEOは記事や内容そのものを最適化したコンテンツSEOと、内部構造やソースコードを最適化したテクニカルSEOに大別できます。コンテンツSEOはコンテンツの評価を上げるために、網羅性や専門性を高めることが重要でした。

テクニカルSEOではURL、HTML、CSS、JavaScriptといった内部構造の最適化、UI・UXの改善、ページスピードの改善、構造化データの公開、ローカルSEO最適化、多言語対応、内部リンク最適化などをします。

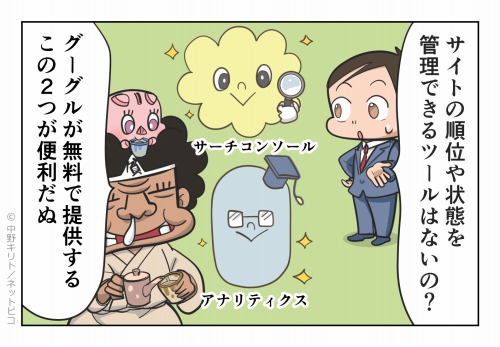

──何かサイトの評価がわかるツールはありますか?

私たちが良質なコンテンツを作成したあとには、ページの状態やページを訪れるユーザーの行動を解析することが、今後の売上の増加につながります。それに必要なツールはGoogle Search Console(サーチコンソール)とGoogle Analytics(アナリティクス)です。

Google Search ConsoleのConsoleとは「制御する」という意味に近いです。サイトを登録することで「検索結果での表示方、キーワード別のクリック数や掲載順位、サイトへのリンク、登録されたページ、エラー」などがわかります。

特に「キーワード別のCTR」は重要です。CTR(Click Through Rate)とはクリック率という意味です。例えば、表示された回数が100回、そのうちクリックされた回数が5回の場合、CTRは「5÷100=5.0%」となります。

Internet Marketing Ninjasの2024年10時点の「Advanced Web Ranking」によると、検索順位別のCTRは「1位27.7%、2位12.9%、3位8.3%、4位5.5%、5位3.9%、6位2.8%、7位2.1%、8位1.6%、9位1.3%、10位1.1%」でした。11~20位はおおむね1.0%前後です。

仮に私たちのページがあるキーワードで1位に表示されているとき、CTRは27.7%に近い値を示すはずですが、Google Search Consoleを確認してみると5.0%しかなかったとします。

この場合、検索結果に表示された記事のタイトルがユーザーにとって、魅力的ではない可能性が高いです。そこで記事のタイトルを改善してみると、CTRは20%に上昇、同じ1位でもアクセス数を4倍にすることができました。

このようにGoogle Search Consoleを定期的に確認して、そこで得られた情報からサイトやページに手を加えてあげることで、より多くのユーザーを呼び込めるようになります。

Google AnalyticsのAnalyticsとは「解析する」という意味です。サイトを登録することで「ユーザーの属性、アクセス数、セッション数、PV(ページビュー)数、平均セッション時間、直帰率、行動フロー」などがわかります。

例えば「PV数÷セッション数」で1人あたりの平均PVが計算できます。その結果「サイト全体の平均PVは4.4ページあるけど、このページは1.2ページしかない」などがわかり、ユーザーを離脱させない対策が打てます。

各ページの表示回数、滞在時間、離脱率などを比較すれば、どのページが人気があるかもわかります。1番よく見られているページにアフィリエイト広告を貼るなどの収益力向上も可能です。

ユーザーがどのような経路でサイトに訪れて、どのような経路でサイトを去っていたかも知ることができます。サイト設計やデザインなどでも数値目標を立てることができ、費用対効果がわかるために便利です。

アフィリエイトの売上と利益だけでは自分のサイトは評価しきれません。ユーザーのためのサイトを作ったら、そのユーザーを解析して、よりユーザーに役立つサイトに改善することが、結果的に売上アップに貢献します。

──外部リンクのIPアドレスは分散していたほうがいいですか?

被リンク元のIPアドレスの分散については「SEOにはまったく影響しない」とされながらも、一部では「分散されたほうが順位が上がる」や「あまりに偏っていると効果はない」などと情報が錯綜しています。

いずれにしても検証に手間がかかることから、2004~2011年にかけて、私はレンタルサーバー会社を分散させてきました。レンタルサーバー会社は「ロリポップ、チカッパ、heteml、XREA、さくらレンタルサーバー、99円サーバー、Step Server、Next Space、Hustle Server」などです。

これらのレンタルサーバー会社を使い分けると、被リンク元のIPアドレスを分散できます。IPアドレスは「第1オクテット.第2オクテット.第3オクテット.第4オクテット」で仕切られており、私はその中でも第1オクテットで分散化しました。

例えば、ロリポップでサーバーを複数借りると、IPアドレスは「210.XX.XX.XX、59.XX.XX.XX、61.XX.XX.XX、219.XX.XX.XX」などになり、第1オクテットが異なるサーバーに振り分けられますし、XREAは「60.XX.XX.XX」、さくらレンタルサーバーは「112.XX.XX.XX」、99円サーバーは「113.XX.XX.XX」となります。

しかしながら、ロリポップは2010年に全サーバーのIPアドレスを、第3オクテットまでが同一の「210.172.144.XX」に変更しました。

以前からロリポップのIPアドレスは「210.172.144.XX」に収束されている傾向が見られましたが、今回は第1オクテットが「210...、59...、61...、219...」から始まるサーバーもすべて「210.172.144.XX」に変わっています。

結果、第1オクテット以下だったIP分散が第3オクテット以下までに一気に格落ちして、ロリポップではIPアドレスの分散ができなくなりました。私はロリポップで40台以上もサーバーを借りていたために、被リンク元のIPアドレスが集約されてしまった格好です。

そこでロリポップに問い合わせてみたところ、すぐに「ご連絡いただいたIPの設定については、2010年4月から行われた新構成サーバーの移設メンテナンスに伴って実施されております」という回答をもらいました。

つまり、IPアドレスは世界全体で枯渇しており、ロリポップも意図的にIPアドレスを減らしています。そもそもIPアドレスに関係なくURLとサーバーは紐付けられるため、レンタルサーバー会社がIPアドレスを複数持つメリットはありません。

今後はロリポップとの新規契約は控えて、国内にある別のレンタルサーバー会社に移し、IPアドレスの分散を続けようか迷いました。ただ、他社もロリポップに続き、IPアドレスを集約する動きを見せています。

海外サーバーはレスポンスが悪いために借りません。レスポンスの遅さはクローラビリティを低下させますし、検索アルゴリズムもマイナスと判断します。さらに同じ国のサーバーからの被リンクのほうが効果的という情報もあります。

結局、ロリポップの2010年4月に行われたIPアドレスの収束化から9カ月が立ち、その間に被リンク元のレンタルサーバーを移管しませんでしたが、私のサイトでは目立った順位変動はありませんでした。

2004~2007年のYahoo!検索では、検索アルゴリズムにIPアドレスの分散を入れていた時期があったようですが、2010年時点のGoogle検索では軽微の影響力もないほどであることがわかりました。

これは被リンクの評価にIPアドレスは関与していない可能性を示唆しています。被リンクに関しては「ドメイン評価、ページ評価、被リンク元の被リンク、コンテンツの関連性、テキストリンク、設置時期」のほうが、はるかに重要度が高いです。

現在ではほとんどのレンタルサーバー会社が共通のIPアドレスでサーバーを構成しているため、GoogleはIPアドレスではなくドメインやページ単位でバックリンクを評価しているように見受けられます。これを機にIPアドレスの分散は気にしないことにしました。

そもそもIPアドレスの分散はレンタルサーバー会社を掛け持ちするくらいで解決できる安直な方法です。これを重要な検索アルゴリズムに組み込むようなことを、Googleが採用するわけがありません。

SEOの体験談や口コミ

アフィリエイト歴11年

Googleは意図的に検索順位をコントロールしようとする行為に対して、ペナルティのようなものを科して、検索順位を下げることがあります。

例えば、検索順位を上げるために恣意的に貼った不自然なリンクがある場合もそうです。Googleは不自然なリンクのほとんどを無視しますが、まれにGoogle Search Consoleに「不自然なリンクを削除してください」という旨の警告が来て、一時的に順位が下がってしまうことがあります。

そのペナルティを解除するためには「Google Search Consoleからバックリンク元をダウンロードする、不自然なリンクを抽出する、リンクの否認をする、再審査リクエストを実施する」の手順が必要です。

アフィリエイト歴2年

少ないコンテンツ量による網羅性の不足、ユーザーエクスペリエンスを損なう広告による可読性の低下、リライトや抽象的な内容による専門性の欠如などは、一般的には低品質なページに該当します。

しかも、それらが総ページ数に対して低品質なページの割合が高いほど、サイト全体のクオリティが低いと評価されるでしょう。

その結果、本来は高品質なページの検索順位が、巻き添えで低下する可能性もあります。私たちはそのドメインやサービス下にあるすべてのページに責任を持ち、サイト全体のクオリティを上げる努力が必要です。